Fue una tarde como cualquier otra, pero con una pizza con queso de trufa. Gracias a los profesionales que me rodean y a las redes sociales, cada vez más escuchaba hablar de la IA, de los nuevos modelos de texto a imagen y de, como no, el miedo de que esto supusiera el fin para miles de creadores visuales.

Mientras comíamos la pizza, empezamos a probar «Dalle-2» en el móvil. Ya habíamos hecho algunas pruebas con Craiyon, pero todavía muy pocas con el nuevo modelo ni con Midjourney y casi que desconocíamos otras opciones como Stable Diffusion.

¿Pero qué tiene que ver las risas en todo esto? Pues porque utilizamos Dalle-2 para una función tan concreta como extravagante: generar imágenes de Cristo Pantocrátor. En aquel momento estaba estudiando el tema del arte Románico para las oposiciones de profesor de dibujo (si quieres saber más sobre esto y su relación con el blog, ¡clica aquí!). Es un tema que no es de mis favoritos, pero esa figura siempre me ha hecho muchísima gracia.

🤪 ¿Y qué ocurrió? Volvimos loco a Dalle-2. 🤪

Prepárate para adentrarte en un post muy divertido, a mitad entre la tecnología y el arte y en el que plasmo mis conclusiones después de usar los modelos de texto a imagen (casi) por primera vez.

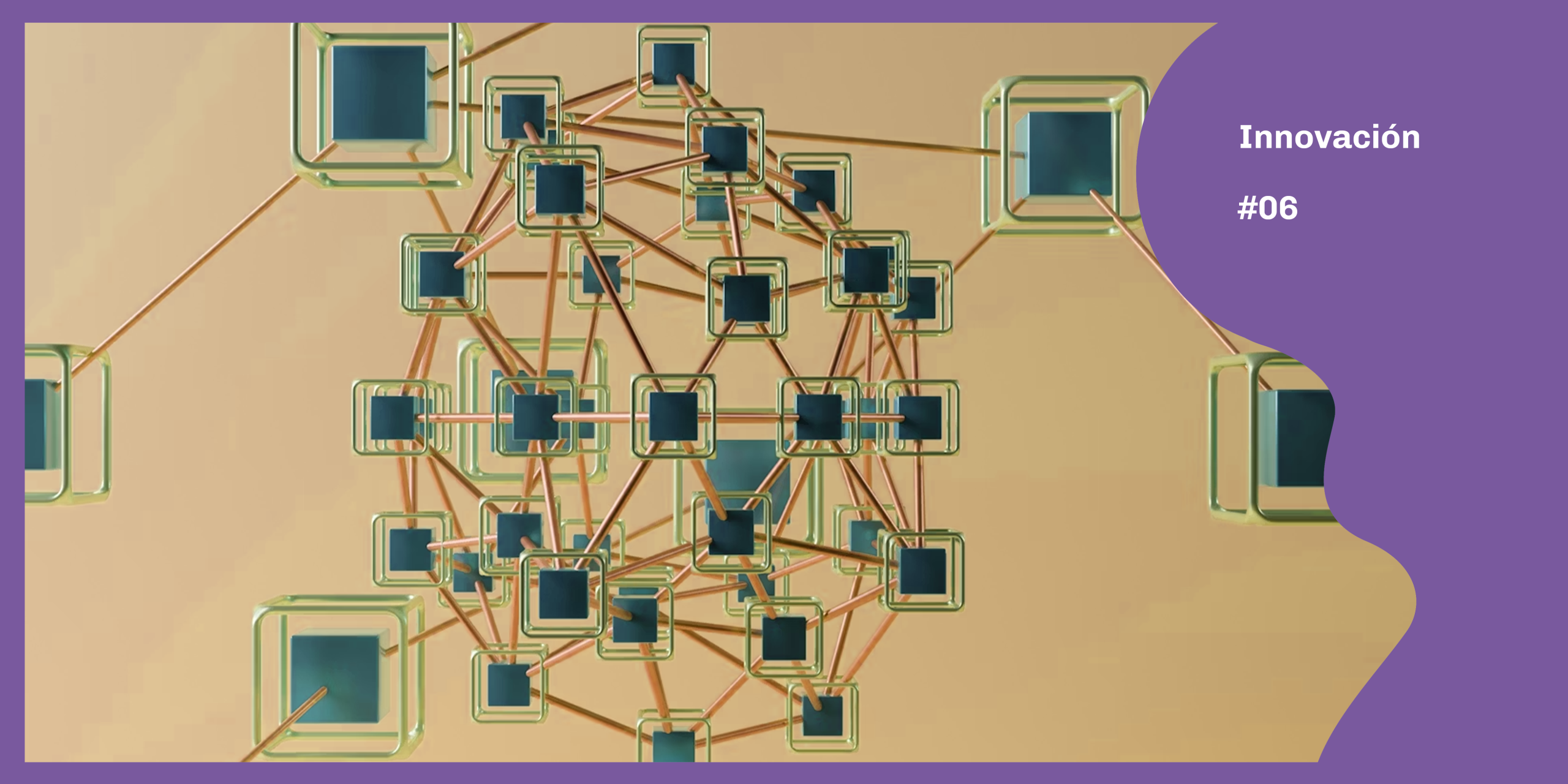

Empezamos dándole un prompt que nos provocaba risa: ver al pantocrátor en estilo heavy metal. No salió bien. Ya que el resultado había sido tan rocambolesco, nos centramos en hacer algo más simple. Un pantocrátor, sin especificar una fecha. Aunque los resultados no eran perfectos, nos sorprendió la capacidad que tuvo para recrear algo tan concreto.

Mediante variaciones de las imágenes y nuevos prompts, hicimos que el pantocrátor sonriese y que tuviera unos colores más vivos, dejando de ser una imagen como las de la historia del arte para ser, cada vez más, una caricatura. Además, introdujimos un cambio que inicialmente no tenía importancia: que el Pantocrátor fuera del periodo bizantino. En este proceso, poco a poco descubrimos cosas de la herramienta que nos resultaron curiosas.

La noche continuó y con ello, las evoluciones del pantocrátor y las risas que ello nos provocaba. Imágenes totalmente sacadas de contexto por ser creadas a partir de las anteriores y colores estridentes que, sin duda, no estaban en las capillas románicas. Es cierto que fue una prueba totalmente loca, pero no exenta de aprendizaje.

Pues lo cierto es que sí. Detrás de todas estas risas, estábamos haciendo un proceso muy interesante. Llevábamos hasta el límite a Dalle-2, explorando todo lo que nos podía ofrecer y cómo era su «proceso creativo». Pero para empezar con este proceso, necesitamos algo esencial: nuestro propio conocimiento.

La herramienta por si sola no nos ofrecía un pantocrátor específico de una época de la historia del arte. Con nuestro conocimiento y aunque solo fuera por diversión, logramos sacar diversos resultados, diferentes entre sí gracias al contexto aportado. No era igual la representación bizantina que la del siglo XII europeo, como tampoco lo es en la vida real. Esto nos hizo descubrir que el modelo texto a imagen podía filtrar por un contexto temporal.

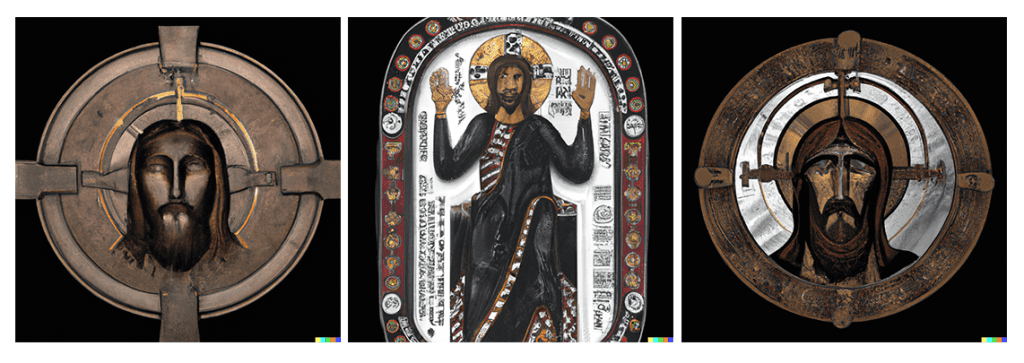

Además, si comparamos con estas imágenes religiosas reales y más cercanas al contexto aportado en el prompt, podemos sacar nuevas conclusiones. La construcción del rostro, del conjunto de barba y cejas son muy similares a los referentes del mismo periodo. También lo es la partición de la aureola que aparece detrás de la cabeza que, tal como sucede también en los modelos eslavos, lleva inscripciones. Si bien los resultados no son una copia ni perfectos, demuestra que hasta en imágenes antiguas esta herramienta es capaz de inspirarse y crear nuevas visiones sobre ellas. También los colores e incluso el fondo granuloso de la segunda imagen nos transmite a los referentes bizantinos. En ellos, el dorado, el azul y el rojo son colores primarios y el grano se corresponde con la forma de las teselas de los mosaicos que cubrían los interiores de las cúpulas.

Sin duda, ese día aprendimos y nos reímos con la IA. Pero también fue la chispa que despertó el interés por estas nuevas tecnologías para la creación artística. Y a partir de ese momento, decidimos seguir investigando.

¡No todo iba a ser románico y bizantino!

Tiempo después, y ya con voluntad puramente de investigación, decidí probar cómo funcionaba esta inspiración con otros artistas, como los del renacimiento o del barroco. Para ello, usaríamos Stable Diffusion y eliminaríamos los ajustes que se pudiesen aplicar, quedándonos con los resultados en la primera descripcion aportada. Es cierto que no es el mismo modelo, pero buscábamos comprobar una sola cosa: en qué grado las imitaciones de estas inteligencias artificiales se ajustaban a las pinturas reales de grandes artistas. Para ello, escogimos tres artistas de diferentes épocas para evaluar la destreza del modelo, así como con qué referente daba mejores resultados.

¿Conseguiremos que Stable Diffusion ilustre algunos elementos con el estilo de cada uno? ¡Vamos a verlo!

Michelangelo Buonarroti es el genio del renacimiento. Pintor, escultor y arquitecto, estuvo al servicio de los papas y nobles de la época, trabajando en Roma y Florencia. Se inspiró en la antigüedad clásica (¡te cuento más sobre esto aquí!) y nos dio grandes obras de la historia del arte como «La piedad», los frescos de la Capilla Sixtina o el David.

Para esta prueba nos centramos en el Buonarroti pintor, dado que la IA va a generar una imagen y no una escultura. No buscamos un resultado refinado, sino un proceso lúdico tal como hicimos con el pantocrátor. Es decir, retar a la IA para obtener el mejor resultado en los prompts más breves. Y esto fue con lo que nos encontramos.

Teniendo en cuenta los condicionantes, pero comparando con una pintura del artista escogido, opinamos que el resultado no se ajusta a lo que podíamos esperar. Si es cierto que el volumen de los brazos, las proporciones del cuello o la posición de la mano pueden traer algunas reminiscencias a las figuras de Miguel Ángel. Pero es casi imposible relacionarlas sin tener los conocimientos o el contexto suficiente.

Tampoco los colores son los que esperábamos, ni el acabado. Es cierto que el fresco de nuestro artista cuenta con siglos de historia, pero la pincelada que nos ofrece Stable Diffusion es empastada, más cercana al óleo que a la técnica escogida por el artista italiano y con colores más saturados y menos variados que los de la Capilla Sixtina.

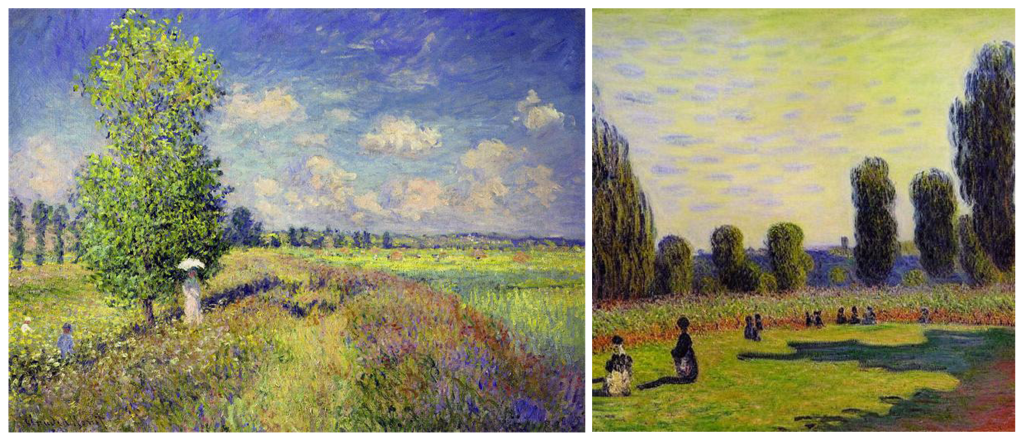

En este caso, probé a representar un paisaje al estilo de Claude Monet. Sin referencias previas y con un prompt muy sencillo, pude ver como esta nueva herramienta entendía (bien por copia o por otros mecanismos) el juego de luces que Monet representaba en sus obras y las formas titubeantes por la pincelada corta y expresiva.

En cambio, también observé que la paleta utilizaba era extremadamente saturada en todos los resultados ofrecidos. Si bien el impresionismo fue el primer movimiento que presta gran atención a la luz y la pintura fuera del estudio (gracias a la invención de los óleos en tubo, que permitieron una mayor movilidad), las obras de Monet generalmente no tienen colores tan saturados. Esta saturación es más propia de autores posteriores como Matisse o el icono del arte pop y las grandes superficies de color, Andy Warhol (a quién estudiaremos a continuación). Aun así, el resultado se ajustaba mejor al artista de lo que lo había hecho anteriormente con Buonarroti.

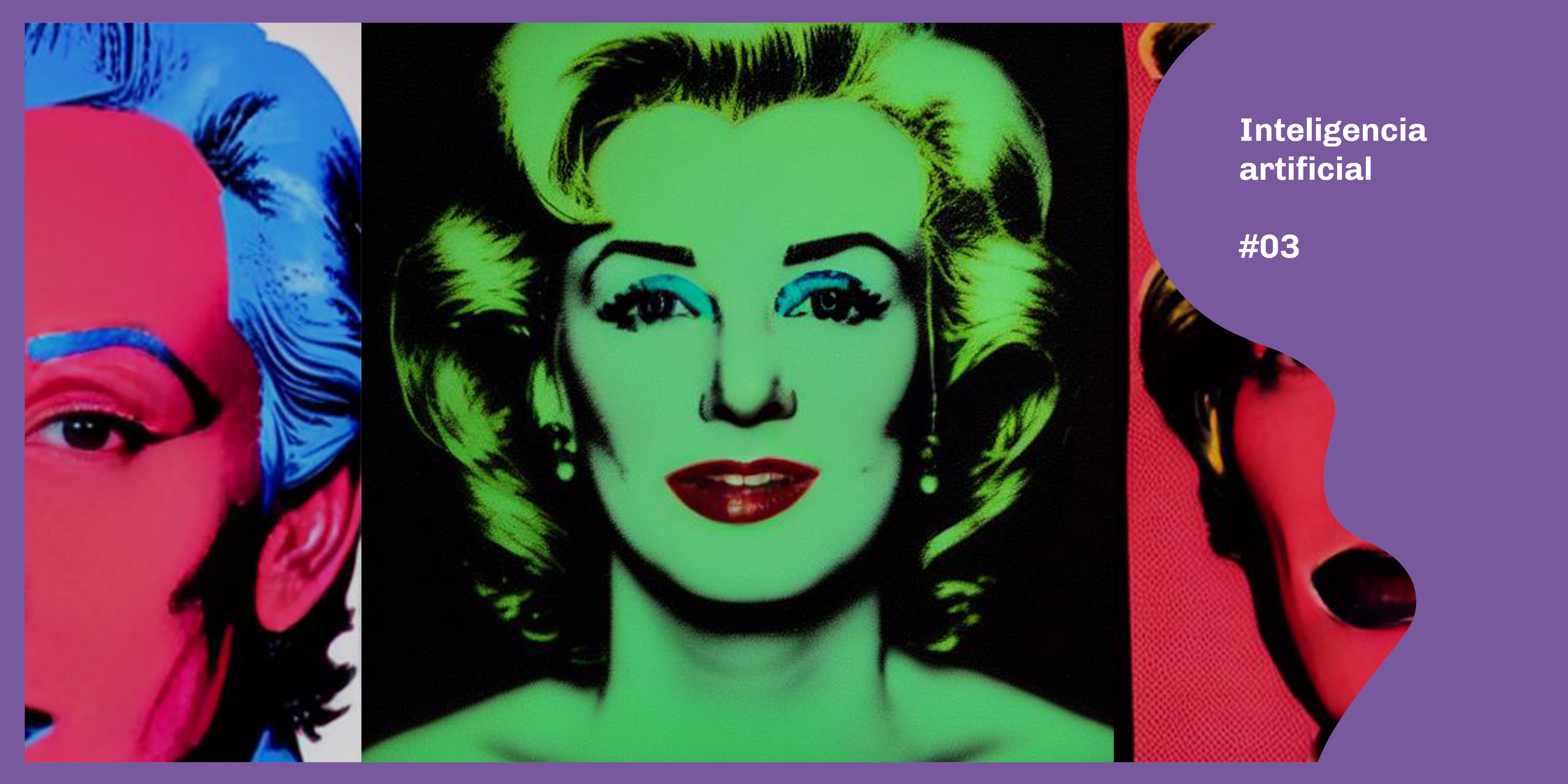

Como último reto, quise adivinar qué tal se le daría a la IA representar un retrato bajo el estilo de uno de los artistas más famosos del siglo XX, Andy Warhol. Warhol, exponente del arte pop, basa su arte y trayectoria en la sociedad de consumo y su funcionamiento. No solo habla sobre ella en sus obras, sino que sus propios resultados se añaden a la rueda que replica las modas del momento y que genera productos para ser consumidos rápidamente por el público, independientemente de su conocimiento artístico (Si quieres saber más sobre este artista polifacético, te dejo este enlace)

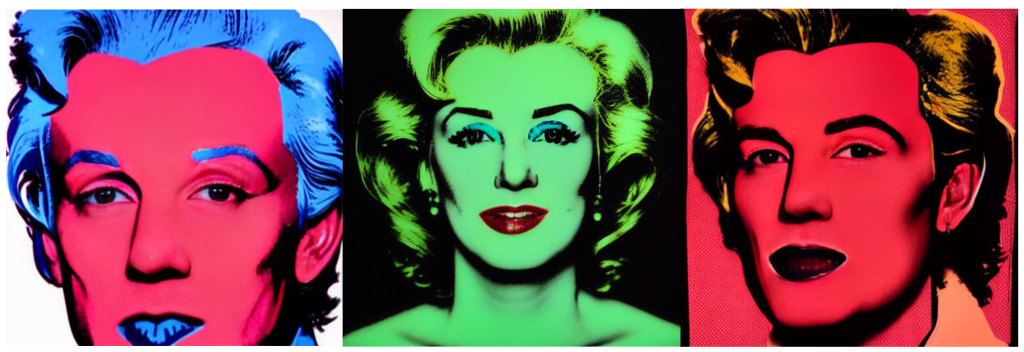

En este caso, y de nuevo con gran sencillez en las definiciones que le aportaba, Stable Diffusion logró ofrecer varios retratos de hombres y mujeres al estilo del artista, con grandes espacios de color plano, propio de la serigrafía. Aunque fueron resultados bastante interesantes, en todos se repetía el patrón del pelo, cejas y labios que caracterizaban el retrato de Marilyn Monroe. Sin embargo, estos ejemplos nos llevan a pensar en que una de las opciones de uso de esta herramienta podía ser generar filtros con este estilo, para ser aplicados a todo tipo de fotos que pudiéramos aportar (tratando de que siempre fueran de frente o 3/4, por ejemplo).

Poco a poco, y tras probar Dalle, Midjourney y Stable Diffusion, me quedó claro que estamos ante una nueva manera de crear digitalmente que va más allá de los softwares habituales (como Adobe). Más allá de si los resultados son ajustados o no a lo que pedimos, poder extraer imágenes con tan solo una breve descripción es una revolución que pone al alcance de todos la capacidad de representar, así como lo hizo la fotografía hace décadas. Con nuestras descripciones pudimos comprobar como esta herramienta diferencia entre épocas a representar, entre referentes o permite jugar con los puntos de vista en las diferentes representaciones.

El descubrimiento de estos modelos de texto a imagen llamó enseguida la atención de miles de personas en todo el mundo, pero tal vez lo más complicado a partir de aquí sea gestionar su uso responsable. En nuestro caso, las imágenes desarrolladas se acotan a descripciones breves, a una investigación sobre las posibilidades y a un uso informativo. En cambio, ya existen grandes polémicas con el alcance de la herramienta y de sus usuarios, algunos de los cuales están basando toda su producción artística en la generación de imágenes con IA (descubre aquí que opina sobre esto ChatGPT, el chat basado en inteligencia artificial). ¿Dónde está el límite? ¿Es esto legal, sabiendo que estas herramientas se entrenan con multitud de imágenes, no siempre libres de derechos?

Y tú, ¿ya has probado la generación de imágenes con estas nuevas herramientas de inteligencia artificial?